датасеты для машинного обучения изображения

Ресурсы для получения датасетов изображений, о которых вы могли не знать

Привет, Хабр! Как известно, топливом для машинного обучения являются наборы данных. В качестве источников для получения датасетов, которыми люди обычно пользуются и которые у всех на слуху, являются такие сайты как Kaggle, ImageNet, Google Dataset Search и Visual Genom, но довольно редко встречаю людей, которые для поиска данных используют такие сайты как Bing Image Search и Instagram. Поэтому в этой статье я покажу как легко получить данные с этих источников, написав две небольшие программы на Python.

Bing Image Search

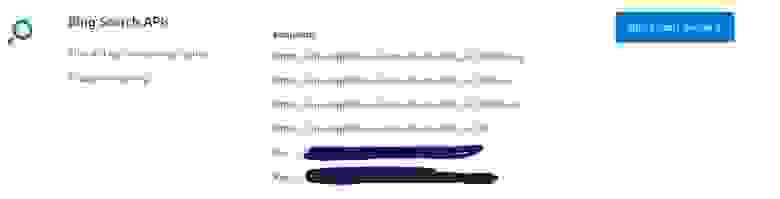

Первое, что нужно сделать это перейти по ссылке нажать кнопку Get API Key и зарегистрироваться с помощью любой из предложенных социальных сетей(Microsoft, Facebook, LinkedIn или GitHub). После того, как процесс регистрации завершится вас перенаправят на страницу Your APIs, которая должна выглядеть подобным образом( то, что замазано, это и есть ваши API ключи) :

Переходим к написанию кода. Импортируем необходимые библиотеки :

Дальше нужно указать некоторые параметры: API ключ( нужно выбрать из двух предложенных ключей один), указать условия поиска, максимальное количество изображений на запрос, а также установим конечный URL :

Теперь напишем три небольшие функции, которые:

1) Создают для каждого условия поиска отдельную папку :

2) Возвращает содержимое ответа сервера в JSON :

3) Записывает изображения на диск :

Далее мы перебираем изображения и пытаемся загрузить каждое отдельное изображение в выходную папку :

Как вы можете видеть, я использую библиотеку selenium, поэтому нужно скачать geckodriver. В инстаграме поиск изображений будем осуществлять по хэштегу, допустим, возьмём хэштег #bird. По данному хэштегу можно найти около 26млн публикаций. Копируем ссылку, которая сформировалась в результате запроса и путь к geckodriver, и вставляем это соответственно в две строчки, которые представлены ниже:

Дальше напишем 6 функций, которые:

1) Входит в инстаграм аккаунт. В строчках login.send_keys(‘ ‘) и password.send_keys(‘ ‘) необходимо вставить свой логин и пароль соответственно:

2) Находит первый пост и нажимаем на него:

Тут необходимо отметить, что, возможно, из-за того, что у всех разрешение экрана монитора разное, то первый пост может находиться по другим координатам, поэтому в методе moveTo() нужно будет поменять первых два параметра.

3) Получаем ссылку на публикацию и нажимаем на кнопку далее:

Тут может возникнуть аналогичная проблема, что и в методе выше: кнопка далее может находиться по другим координатам.

4)Получаем html-код исходной страницы:

5) Получаем URL изображения:

6) Скачиваем и сохраняем текущее изображение. В переменной filename нужно указать по какому пути будет сохраняться ваше изображение:

Заключение

В заключении хотелось бы сказать про недостаток источников и реализации. Что касается самих ресурсов, то изображений с них можно собрать большое количество, но эти данные придётся сортировать, так как изображения не всегда подходят под те критерии поиска, которые вы задали. Что касается реализации, то в получении данных с инстаграма была задействована библиотека pyautogui, которая эмулирует действия пользователя, в результате чего, при выполнении программы вы не сможете задействовать ваш компьютер для решения других задач. Если будут предложения, как написать код лучше, прошу писать в комментарии.

Что касается написания кода, то всё было сделано на Ubuntu 18.04. Исходный код выложил на GitHub.

30 самых крупных датасетов для машинного обучения в TensorFlow

TensorFlow — это одна из наиболее популярных открытых библиотек с датасетами для задач машинного обучения. Разработкой TensorFlow занимаются исследователи из Google Brain. Библиотека предоставляет доступ к датасетам с изображениями, видео, аудио и текстами.

Датасеты изображений

1. CelebA : один из наиболее крупных публичных датасетов с изображениями лиц. Celebrity Faces Attributes Dataset (CelebA) состоит из более чем 200 тысяч изображений знаменитостей.

2. Downsampled Imagenet : датасет собирали для оценки глубины изображений и задач генерации. Он содержит более 1.3 миллионов изображений объектов, сцен, транспортных средств, людей и т.п.

3. Lsun – это набор широкомасштабных изображений, который используется для задач оценки сцены (scene understanding). Датасет содержит более 9 миллионов изображений сцен, которые поделены на категории.

4. Bigearthnet содержит изображения с воздуха со спутника Sentinel-2.

5. Places 365 состоит из 1.8 миллионов изображений разных мест и сцен, включая офис, коттедж и пирс.

6. Quickdraw Bitmap – это набор изображений, нарисованных с помощью Quickdraw. Он состоит из 5 миллионов рисунков 345 категорий.

7. SVHN Cropped – это датасет от Stanford University для обучению моделей распознавания цифр.

8. VGGFace2 – один из наиболее крупных датасетов с изображениями. Он состоит из изображений, собранных с помощью Google поиска.

9. COCO собирали в коллаборации Google, FAIR, Caltech и других организаций. COCO создавали для задач распознавания объектов и сегментации объектов на изображении.

10. Open Images Challenge 2019 состоит из 9 миллионов изображений. Является одним из самых крупных размеченных датасетов для задач компьютерного зрения.

11. Open Images V4 – это одна из версий датасета Open Images. V4 содержит 14.6 миллиона границ объектов для объектов 600 классов.

12. AFLW2K3D содержит 2 тысячи изображений лица с разметкой ключевых точек.

Обработка видеозаписей

13. UCF101 предназначен для обучения моделей распознавания действий. Состоит из 13,320 видео, в которых запечатлены действия из 101 категорий.

14. BAIR Robot Pushing – это набор из 44 тысяч видео, где робот совершает толкающие действия

16. EMNIST – это расширенный MNIST.

Обработка аудиозаписей

17. CREMA-D – датасет для распознавания эмоций по записи голоса. Содержит 7 тысяч аудиоклипов.

18. Librispeech – это 1 тысяча часов английской речи, которую собрали из аудиокниг.

19. Libritts содержит 585 часов английской речи. Датасет создавали при помощи исследователей из Google Brain.

20. TED-LIUM – это датасет, который состоит из 110 часов английской речи из TED выступлений, который также имеют транскрипт.

21. VoxCeleb – набор аудио для задачи идентификации говорящего с аудиофайлами 1,251 спикеров.

Текстовые датасеты

22. C4 (Common Crawl’s Web Crawl Corpus) содержит отфильтрованные тексты вебстраниц из Common Crawl на более чем 40 языках.

23. Civil Comments – это архив 1.8 миллиона примеров публичных комментариев с англоязычных новостных сайтов.

24. IRC Disentanglement содержит более 77 тысяч комментариев из обсуждений Ubuntu IRC Channel.

25. Lm1b состоит из 1 миллиарда слов. Изначально корпус использовали для оценки статистических языковых моделей.

26. SNLI ( Stanford Natural Language Inference Dataset) является корпусов 570 тысяч пар предложений, которые были написаны людьми.

27. e-SNLI – это расширение SNLI датасета, в который добали разметку пар предложений.

28. MultiNLI состоит из 433 тысяч пар предложений.

29. Wiki40b – это набор статей на Wikipedia на 40 языках. Данные отфильтровали и оставили только содержательный текст страниц.

30. Yelp Polarity Reviews содержит полярные отзывы на Yelp, более 580 тысяч отзывов.

«Велосипедный набор» или о создании самодельных датасетов для анализа и машинного обучения

Несколько лет назад я ненадолго увлекся машинным обучением и анализом данных, даже написал небольшой цикл о моем погружении в этот удивительный мир, с точки зрения полного новичка.

Как часто бывает при изучении чего-то нового, мне очень хотелось сделать свой «велосипед». К сожалению, в математике и программировании я разбираюсь плохо, поэтому кандидатом на роль «велосипеда» стал собственный датасет.

С того момента прошло уже больше двух лет и вот у меня дошли руки поделится с вами своим небольшим опытом.

В статье мы рассмотрим несколько потенциальных источников для самостоятельного сбора данных (в том числе не очень популярных), а также попробуем найти в этом процессе хоть какую-то пользу.

Часть I: Введение

Из вступительной части вы наверняка уже догадались, что я не гуру анализа данных и машинного обучения. Пионером в области поиска источников открытых данных меня тоже сложно назвать. Поэтому в данной статье речь пойдет не о хороших практиках, а об утолении «зуда в руках» в случае, если вам пришла в голову идея создать свой датасет.

Прошу вас не воспринимать мою статью слишком серьезно.

С момента задумки статьи до её реализации много воды утекло. Ситуация с доступом к открытым данным становится все лучше и лучше. На Хабре за это время появились хорошие подборки различных источников (например, зарубежных), но я все же решил внести свои «5 копеек».

Итак, пришла пора сбросить гнет чужих наборов данных и создать свой «лучший в мире» набор данных, чтобы скормить его потом алгоритму или просто построить «самый эксклюзивный» график на свете.

Часть II: Источники данных

Порталы с открытыми данными можно разделить на несколько категорий.

Специальные порталы с данными для машинного обучения и анализа

На этих порталах как правило данные собраны в форматы удобные для машинного анализа. Остается их только скачать и загрузить.

Мне в первую очередь вспоминается Kaggle. На Хабре уже есть хорошая статья про наборы данных у Kaggle и инструменты самостоятельного поиска датасетов для машинного обучения.

Поскольку цель нашей сегодняшней статьи не столько сделать хорошо, сколько сделать что-то самостоятельно с нуля, мы продолжим движение в сторону менее популярных ресурсов.

Порталы открытых данных различных гос. органов и общественных организаций

Хотя концептуально «Открытое правительство» в России начало формироваться в начале 2010-х годов, лично мне более-менее адекватные данные обычно удавалось найти примерно за период с 2015 года и позже.

На Хабре уже есть критика порталов с открытыми данными РФ от 2017 года. С тех пор ситуация стала лучше. У некоторых порталов даже появись API для доступа. Однако, все равно остается ощущения, что часто данные собирается по принципу: «Нам тут начальство приказало данные открыть, вот вам кушаете не обляпайтесь».

Рассмотрим основные популярные порталы открытых данных.

Портал открытых данных РФ

Портал оставляет не однозначное впечатление. С одной стороны, у портала есть API для доступа к данным и множество разных датасетов.

С другой стороны на портале, часто можно встретить заброшенные и бесполезные наборы данных, например:

С другой стороны есть люди, которые ответственно выполняют свою работу. Например, данные о величине муниципального долга Ровеньского района и данные об Исполнение бюджетов сельских поселений Ровеньского района ведутся вполне добросовестно и регулярно. Если вы «смелый, ловкий и умелый то. » вполне можете из этих двух наборов создать один, найти аномальные выбросы, несоответствия или даже корреляции между данными.

Я думаю, результат получится не менее убедительным чем на графике про связь фильмов Николаса Кейджа и падение людей в бассейн.

Портал открытых г. Москвы

У портала открытых данных г. Москвы, тоже есть API для доступа к данным.

Сами данные при этом ведутся более порядочно, чем у федерального ресурса.

На сайте есть как геоданные (объекты с привязкой к координатам), так и просто статистика.

В качестве достаточно простого кейса по созданию своего набора данных можно например, скрестить два набора данных и поискать зависимости между данными вызовов подразделений пожарно-спасательного гарнизона города Москвы по административным округам и данными по количеству выявленных общественными пунктами охраны порядка в городе Москве фактов незаконной сдачи жилья в аренду (поднаем) по административным округам Если найдете что-нибудь интересное отпишитесь в комментарии.

Другие стандартизованные источники

У «Северной столицы», тоже есть свой портал открытых данных.

И у других городов РФ тоже есть аналогичные порталы, но они остаются вам на самостоятельное изучение.

Открытые данные можно найти у разных министерств и ведомств, например, у Минтруда.

Также вполне интересно изучить открытые данные Республики Беларусь.

Сайты с информацией

Помимо ресурсов, в том или ином виде адаптированных под концепцию «Открытого правительства» существует множество других сайтов с полезной статистической информацией, например:

Отчеты, аналитические записки и прочие данные для ручной обработки

На мой взгляд больше всего погрузится в процесс сбора данных помогает именно их получение в ручном режиме. Для этого не обязательно брать очень большой набор данных. В принципе источников для сбора данных великое множество.

Лично я начал с обращений граждан. Сейчас практически каждый орган исполнительной власти, в том или ином виде отчитывается за работу с обращениями граждан.

Я в свое время собрал данные мэрии Москвы. Мэрия предлагает нам данные о количестве обращений в бумажном и электронном форматах, количестве положительных и отрицательных решений и относительному количеству обращений по административным округам Москвы. Всю эту информацию с января 2016 по август 2020 я выложил на GitHub.

Вы можете попробовать обработать данные по другим городам, например по Санкт-Петербургу, Твери или Новосибирску.

Также интересные данные можно найти в отчетах по травматизму, например, в сфере энергетики (Ростехнадзор, Минэерго).

Часть III: Есть ли от этого польза?

На самом деле в силу малого опыта в анализе данных ответить на вопрос заголовка убедительно мне будет затруднительно. Может быть матерые специалисты скажут, что в создании своего набора данных смысла нет и это пустая трата времени.

Но вот, что полезного я вынес для себя в итоге:

Часть IV: Заключение

Подводя итог хочется призвать всех, кто только начал интересоваться машинным обучением и анализом данных попробовать создать своё «велосипед», причем не только датасеты но и программную часть, чтобы наука о данных не казалось вам магией.

Вот и закончилась статья, которую я не мог написать больше двух лет, но как говорится: «Лучше поздно чем никогда», прям на душе стало спокойно.

Желаю всем бодрого настроения и здоровья в эти нелегкие осенние месяцы.

Если кто-нибудь соберет свой интересный датасет или получит интересные результаты анализа собственных датасетов, пишите в комментарии.

UPD:

Статья на Хабре про источники с датасетами изображений от wadik69

Топливо для ИИ: подборка открытых датасетов для машинного обучения

Связанные проекты сообщества Open Data (проект Linked Open Data Cloud). Многие датасеты на этой диаграмме могут включать в себя данные, защищенные авторским правом, и они не упоминаются в данной статье

Если вы прямо сейчас не делаете свой ИИ, то другие будут делать его вместо вас для себя. Ничто более не мешает вам создать систему на основе машинного обучения. Есть открытая библиотека глубинного обучения TensorFlow, большое количество алгоритмов для обучения в библиотеке Torch, фреймворк для реализации распределенной обработки неструктурированных и слабоструктурированных данных Spark и множество других инструментов, облегчающих работу.

Добавьте к этому доступность больших вычислительных мощностей, и вы поймете, что для полного счастья не хватает лишь одного ингредиента — данных. Огромное количество данных находится в открытом доступе, однако непросто понять, на какие из открытых датасетов стоит обратить внимание, какие из них годятся для проверки идей, а какие могут быть полезны в качестве средства проверки потенциальных продуктов или их свойств до того, как вы накопите собственные проприетарные данные.

Мы разобрались в этом вопросе и собрали данные по датасетам, удовлетворяющим критериям открытости, востребованности, скорости работы и близости к реальным задачам.

Компьютерное зрение

Открытость данных для машинного обучения — это как бесплатное электричество для рынка электрокаров. Поэтому большой вклад в процесс получения новых датасетов вносят исследовательские группы, которые не гонятся за прямой финансовой выгодой. Так, международная группа исследователей, в которую вошли ученые из Стэнфордского университета, а также представители компании Yahoo и Snapchat, разработала новую базу данных Visual Genom и алгоритм оценки изображений, которые позволят системам искусственного интеллекта понимать, что происходит на снимках. Все изображения в базе Visual Genome маркируются таким образом, чтобы содержать информацию обо всех объектах на снимке, их особенностях и связях.

Ранее исследователи из Стэнфордского университета представили датасет ImageNet, который содержит более миллиона изображений, маркированных по содержанию представленного на снимке события. У многих компаний, создающих API для работы с изображениями, в REST-интерфейсах используются лейблы, подозрительно похожие на 1000-категорийную иерархию WordNet из ImageNet.

MIAS (Mammographic Image Analysis Society)

Датасет по мамограммам, на которых врачи могут с помощью алгоритмов распознавать раковые опухоли. Массив представляет собой реальные снимки груди с известными типами заболеваний.

Landsat-8 — это спутник дистанционного зондирования Земли, выведенный на орбиту в 2013 году. Спутник собирает и сохраняет многоспектральные изображения среднего разрешения (30 метров на точку). Данные Landsat-8 доступны с 2015 года вместе с некоторыми выборочными снимками 2013–14 годов. Все новые снимки Landsat-8 появляются каждый день буквально через несколько часов после их создания.

База данных рукописного написания цифр, имеющая подготовленный набор обучающих значений, в размере 60 000 изображений для обучения и 10 000 изображений для тестирования. Цифры, взятые из набора образцов Бюро переписи населения США (с добавлением тестовых образцов, написанных студентами американских университетов), нормализованы по размеру и имеют фиксированный размер изображения. Эта база является стандартом, предложенным Национальным институтом стандартов и технологий США с целью калибровки и сопоставления методов распознавания изображений.

Следующая ступень эволюции для тех, кто прошел рукописные цифры. Этот датасет включает в себя 74 000 изображений различных символов (алфавит, цифры и т.д.).

Данные биометрического распознавания (фронтальное изображение лица), полученные с помощью движка с открытым исходным кодом.

Номера домов из Google Street View. 73 257 номеров для обучения, 26 032 номера для тестирования и 531 131 несколько менее сложный образец, чтобы использовать в качестве дополнительных учебных данных.

Естественные языки

Корпус данных веб-страниц объемом более 540 терабайт — состоит из более 5 миллиардов веб-страниц. Этот набор данных свободно доступен на Amazon S3.

Yelp — сайт для поиска на местном рынке услуг, например, ресторанов или парикмахерских, с возможностью добавлять и просматривать рейтинги и обзоры этих услуг. За долгие годы работы накопил огромное количество данных от пользователей сервиса. Набор данных включает в себя 4 700 000 отзывов на 156 000 компаний от более 1 000 000 пользователей.

Набор данных представляет собой коллекцию текста из более чем 100 млн словоупотреблений, извлеченных из проверенных Хороших и Избранных статей Википедии.

Этот набор новостных статей CNN содержит 120 000 пар вопросы + контекст/ответы. Вопросы написаны людьми на естественном языке. На вопросы могут отсутствовать ответы, а ответы могут быть многоязыковыми. Набор данных Maluuba разработан, чтобы помочь создать «умных» чат-ботов, которые могут поддерживать принятие решений в сложных условиях.

Базовые данные, состоящие из пар (вопросы + контекст/ответы), извлеченных из детских книг, доступных в рамках Проекта Гутенберг, направленного на создание и распространение электронной универсальной библиотеки. Проект, основанный в 1971 году, предусматривает оцифровку и сохранение в текстовом формате различных произведений мировой литературы — в основном это тексты, находящиеся в свободном доступе на всех популярных мировых языках. Для бесплатной загрузки доступно более 53 000 документов.

Датасет анализа тональности «комментариев» в Twitter. Содержит 1 578 627 твитов с указанием положительных и отрицательных настроений.

Всеобъемлющий словарь звуковых событий. 632 класса аудиособытий и коллекция из 2 084 320 голосовых 10-секундных отрезков из видео на YouTube (более 5 тысяч часов аудиозаписей).

Датасет англоязычной речи, содержащий стенограммы 40 телефонных переговоров на английском языке. Данные 2000 HUB5 English сосредоточены на разговорной речи по телефону с конкретной задачей транскрипции речи в текст.

Аудиозаписи 1495 выступлений на TED с полной расшифровкой.

«Датасет» датасетов

Mldata (machine learning data set repository) — репозиторий набора данных для машинного обучения, содержащий более 800 общедоступных архивных наборов данных с рейтингами, представлениями, комментариями.

Крупнейший репозиторий реальных и модельных задач машинного обучения, ведущий свою историю с 1987 года. Содержит реальные данные по прикладным задачам биологии, медицины, физики, техники, социологии и других сфер, ставшие классическими для работы различных алгоритмов. Датасеты этого репозитория часто используются научным сообществом для эмпирического анализа алгоритмов машинного обучения. Включает интересные данные по текстам из спам-писем UCI’s Spambase, которые можно использовать в качестве платформы для обучения персонализированных спам-фильтров.

Датасеты для «Элементов статистического обучения», созданные под руководством профессора Стэнфордского университета Тревора Хасти, представляют собой наборы данных в различных категориях, таких как минеральная плотность костей скелета, страны, галактика, информационные данные по маркетингу, спам, почтовые индексы и многих других.

AWS предлагает несколько интересных датасетов, включая всю электронную почту Enron, синтаксические n-граммы Google Books, данные NASA NEX (информация о климате, геологии и состоянии мировой флоры объемом более 20 терабайт) и многое другое.

Эта платформа, где все пользователи могут обмениваться своими датасетами. У них более 350 датасетов и более 200 из них значатся в качестве рекомендуемых платформой.

Несколько сотен датасетов, классифицированных по различным категориям в разных областях. Увы, не содержит описания самих датасетов.

Проект data.world сам о себе говорит как о «социальной сети для людей с датасетами», но правильнее описать его как «GitHub для данных». Это место, где вы можете искать, копировать, анализировать и загружать датасеты. Кроме того, вы можете загрузить свои данные в data.world и использовать его для совместной работы с другими пользователями.

Одно из ключевых отличий data.world — это инструменты, которые они создали для упрощения работы с данными. Система поддерживает SQL-запросы для изучения данных и объединения нескольких датасетов, у них также есть SDK, упрощающий работу с данными в выбранном вами инструменте (подробно об этом можно прочитать в tutorial on the data.world Python SDK).

Разработчики часто забывают, что при создании новых ИИ-решений или продуктов самое сложное — не алгоритмы, а сбор и маркирование коллекции данных. Стандартные датасеты могут использоваться для валидации или в качестве отправной точки построения более специализированного решения.

Другое популярное заблуждение кроется в идее, что решение проблем, связанных с одним датасетом, равнозначно тщательному продумыванию всего своего продукта. Используйте эти датасеты для валидации или проверки своих идей, но не забывайте тестировать или прототипировать работу продукта, и добудьте новые, более достоверные данные, которые помогут отточить ваш продукт. Успешные компании, чей бизнес построен на данных, обычно уделяют много внимания сбору новых, проприетарных данных, позволяющих повысить производительность без увеличения рисков.

Источники (по ссылкам вы также найдете еще больше примеров интересных датасетов):