вшэ введение в машинное обучение

Вшэ введение в машинное обучение

Learning Objectives

Expected Learning Outcomes

Course Contents

This introduction to the specialization provides you with insights into the power of machine learning, and the multitude of intelligent applications you personally will be able to develop and deploy upon completion.

We also discuss who we are, how we got here, and our view of the future of intelligent applications.

We will explore this idea within the context of our first case study, predicting house prices, where you will create models that predict a continuous value (price) from input features (square footage, number of bedrooms and bathrooms. ).

This is just one of the many places where regression can be applied.Other applications range from predicting health outcomes in medicine, stock prices in finance, and power usage in high-performance computing, to analyzing which regulators are important for gene expression.

You will also examine how to analyze the performance of your predictive model and implement regression in practice using a Jupyter notebook.

In our second case study, analyzing sentiment, you will create models that predict a class (positive/negative sentiment) from input features (text of the reviews, user profile information. ).This task is an example of classification, one of the most widely used areas of machine learning, with a broad array of applications, including ad targeting, spam detection, medical diagnosis and image classification.

You will analyze the accuracy of your classifier, implement an actual classifier in a Jupyter notebook, and take a first stab at a core piece of the intelligent application you will build and deploy in your capstone.

In this third case study, retrieving documents, you will examine various document representations and an algorithm to retrieve the most similar subset. You will also consider structured representations of the documents that automatically group articles by similarity (e.g., document topic).

You will actually build an intelligent document retrieval system for Wikipedia entries in an Jupyter notebook.

You will learn how to build such a recommender system using a variety of techniques, and explore their tradeoffs.

One method we examine is matrix factorization, which learns features of users and products to form recommendations. In a Jupyter notebook, you will use these techniques to build a real song recommender system.

In our final case study, searching for images, you will learn how layers of neural networks provide very descriptive (non-linear) features that provide impressive performance in image classification and retrieval tasks. You will then construct deep features, a transfer learning technique that allows you to use deep learning very easily, even when you have little data to train the model.

Using iPhython notebooks, you will build an image classifier and an intelligent image retrieval system with deep learning.

Платформа»Онлайн-образование в НИУ ВШЭ»

Не так давно получил распространение термин «большие данные», обозначивший новую прикладную область — поиск способов автоматического быстрого анализа огромных объёмов разнородной информации. Наука о больших данных ещё только оформляется, но уже сейчас она очень востребована — и в будущем будет востребована только больше.

С её помощью можно решать невероятные задачи: оценивать состояние печени по кардиограмме, предсказывать зарплату по описанию вакансии, предлагать пользователю музыку на основании его анкеты в интернете. Большими данными может оказаться что угодно: результаты научных экспериментов, логи банковских транзакций, метеорологические наблюдения, профили в социальных сетях — словом, всё, что может быть полезно проанализировать. Самым перспективным подходом к анализу больших данных считается применение машинного обучения — набора методов, благодаря которым компьютер может находить в массивах изначально неизвестные взаимосвязи и закономерности. На факультете компьютерных наук ВШЭ и в Школе анализа данных есть люди, активно использующие машинное обучение и разрабатывающие новые подходы к нему. Именно они — преподаватели этого курса.

Вы изучите основные типы задач, решаемых с помощью машинного обучения — в основном речь пойдёт о классификации, регрессии и кластеризации. Узнаете об основных методах машинного обучения и их особенностях, научитесь оценивать качество моделей — и решать, подходит ли модель для решения конкретной задачи. Наконец, познакомитесь с современными библиотеками, в которых реализованы обсуждаемые модели и методы оценки их качества. Для работы мы будем использовать реальные данные из реальных задач.

Курс включает в себя 12 недель обучения.

Слушателю нужно знать об основных понятиях математики: функциях, производных, векторах, матрицах. Для выполнения практических заданий потребуются базовые навыки программирования. Очень желательно знать Python. Задания рассчитаны на использование этого языка и его библиотек numpy, pandas и scikit-learn.

3 зачетных единицы

Знакомство с анализом данных и машинным обучением

В первом модуле курса мы расскажем о задачах, которые решает машинное обучение, определим базовый набор понятий и введем необходимые обозначения. Также мы расскажем про основные библиотеки языка Python для работы с данными (NumPy, Pandas, Scikit-Learn), которые понадобятся для выполнения практических заданий на протяжении всего курса.

Логические методы классификации

Логические методы делают классификацию объектов на основе простых правил, благодаря чему являются интерпретируемыми и легкими в реализации. При объединении в композицию логические модели позволяют решать многие задачи с высоким качеством. В этом модуле мы изучим основной класс логических алгоритмов — решающие деревья. Также мы поговорим про объединение деревьев в композицию, называемую случайным лесом.

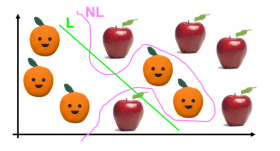

Метрические методы классификации

Метрические методы проводят классификацию на основе сходства, благодаря чему могут работать на данных со сложной структурой — главное, чтобы между объектами можно было измерить расстояние. Мы изучим метод k ближайших соседей, а также способ его обобщения на задачи регрессии с помощью ядерного сглаживания.

Линейные методы классификации

Линейные модели — один из наиболее изученных классов алгоритмов в машинном обучении. Они легко масштабируются и широко применяются для работы с большими данными. В этом модуле мы изучим метод стохастического градиента для настойки линейных классификаторов, познакомимся с регуляризацией и обсудим некоторые тонкости работы с линейными методами.

Метод опорных векторов и логистическая регрессия

Линейные методы имеют несколько очень важных подвидов, о которых пойдет речь в этом модуле. Метод опорных векторов максимизирует отступы объектов, что тесно связано с минимизацией вероятности переобучения. При этом он позволяет очень легко перейти к построению нелинейной разделяющей поверхности благодаря ядровому переходу. Логистическая регрессия позволяет оценивать вероятности принадлежености классам, что оказывается полезным во многих прикладных задачах.

Метрики качества классификации

В машинном обучении существует большое количество метрик качества, каждая из которых имеет свою прикладную интерпретацию и направлена на измерение конкретного свойства решения. В этом модуле мы обсудим, какие бывают метрики качества бинарной и многоклассовой классификации, а также рассмотрим способы сведения многоклассовых задач к двухклассовым.

Линейная регрессия

В этом модуле мы изучим линейные модели для регрессии и обсудим их связь с сингулярным разложением матрицы «объекты-признаки».

Понижение размерности и метод главных компонент

В прикладных задачах часто возникает потребность в уменьшении количества признаков — например, для ускорения работы моделей. В этом модуле мы обсудим подходы к отбору признаков, а также изучим метод главных компонент, один из самых популярных методов понижения размерности.

Композиции алгоритмов

Объединение большого числа моделей в композицию может значительно улучшить итоговое качество за счет того, что отдельные модели будут исправлять ошибки друг друга. В этом модуле мы обсудим основные понятия и постановки задач, связанные с композициями, и обсудим один из наиболее распространенных способов их построения — градиентный бустинг.

Нейронные сети

Нейронные сети позволяют находить сложные нелинейные разделяющие поверхности, благодаря чему широко используются в таких трудных задачах, как распознавание изображений и речи. В этом модуле мы изучим многослойные нейронные сети и их настройку с помощью метода обратного распространения ошибки. Также мы поговорим о глубоких нейросетях, их архитектурах и особенностях.

Кластеризация и визуализация

Этот модуль посвящен новому классу задач в машинном обучении — обучению без учителя. Под этим понимаются ситуации, в которых нужно найти структуру в данных или произвести их «разведку». В этом модуле мы обсудим две таких задачи: кластеризацию (поиск групп схожих объектов) и визуализацию (отображение объектов в двух- или трехмерное пространство).

Частичное обучение

Под частичным обучение понимается задача, находящаяся между обучением с учителем и кластеризацией: дана выборка, в которой значение целевой переменной известно лишь для части объектов. Такие ситуации встречаются, когда разметка объектов является дорогой операцией, но при этом достаточно дешево можно подсчитать признаки для объектов. В этом модуле мы обсудим отличия частичного обучения от рассмотренных ранее постановок, и разберем несколько подходов к решению.

Машинное обучение в прикладных задачах

В этом модуле мы подведем итоги курса, вспомним основные этапы решения задачи анализа данных. Также мы разберем несколько задач из прикладных областей, чтобы подготовиться к выполнению финального проекта.

Основы машинного обучения

понадобится для освоения

для зачета в своем вузе

Курс посвящён основам анализа данных и машинного обучения. По результатам слушатели освоят способы предобработки и визуализации данных, изучат основные методы машинного обучения (линейные, метрические, решающие деревья и их композиции), научатся оценивать качество моделей. Курс пригодится всем, кто хочет «с нуля» погрузиться в область машинного обучения, получить первые практические навыки и начать применять их для решения собственных задач по извлечению пользы из данных.

О курсе

Курс посвящён основам анализа данных и машинного обучения. По результатам слушатели освоят способы предобработки и визуализации данных, изучат основные методы машинного обучения (линейные, метрические, решающие деревья и их композиции), научатся оценивать качество моделей. Практика проходит на языке Python и основана на библиотеках pandas, matplotlib, scikit-learn. Для успешного прохождения курса требуются знания математики на уровне школьных курсов, а также навыки программирования на Python. Контроль на курсе представлен в виде заданий на программирования, заданий на построение выводов (проверяются с помощью взаимного оценивания), а также тестов на знание теоретического материала.

Формат

Курс состоит из 11 недель, каждая включает в себя несколько коротких видеолекций (суммарная продолжительность — от 60 до 90 минут), тест на знание теоретического материала (5-15 вопросов), а также тест, включающий в себя выполнение задания по программированию. На некоторых неделях задание по программированию заменено заданием на взаимное оценивание. В конце курса предусмотрен итоговый экзамен, состоящий из тестов.

Информационные ресурсы

Python, библиотеки numpy, pandas, matplotlib, seaborn, scikit-learn

Требования

Освоение школьного курса математики, навыки программирования на Python

Программа курса

понадобится для освоения

для зачета в своем вузе

Соколов Евгений Андреевич

Должность: Старший преподаватель факультета компьютерных наук, Департамент больших данных и информационного поиска

Зимовнов Андрей Вадимович

Должность: Старший преподаватель факультета компьютерных наук, Департамент больших данных и информационного поиска

Ковалев Евгений Игоревич

Должность: Приглашенный преподаватель факультета компьютерных наук, Департамент больших данных и информационного поиска

Кохтев Вадим Михайлович

Должность: Приглашенный преподаватель факультета компьютерных наук, Департамент больших данных и информационного поиска

Рысьмятова Анастасия Александровна

Магистр

Должность: Приглашенный преподаватель факультета компьютерных наук, Департамент больших данных и информационного поиска

Филатов Артём Андреевич

Должность: Приглашенный преподаватель факультета компьютерных наук, Департамент больших данных и информационного поиска

Машинное обучение 1

Содержание

О курсе

Курс читается для студентов 3-го курса ПМИ ФКН ВШЭ в 1-2 модулях.

Проводится с 2016 года.

Полезные ссылки

Почта для сдачи домашних заданий (на самом деле задания сдаются в AnyTask, но если он не работает, то присылайте на почту): hse.cs.ml+ @gmail.com (например, hse.cs.ml+171@gmail.com)

Чат в telegram для обсуждений (предназначение чата до конца не ясно, вопросы может быть правильнее задавать в чатах групп): https://t.me/joinchat/NRpKJ09prtRlMTli

Оставить отзыв на курс: форма

Вопросы по курсу можно задавать в телеграм лектору (esokolov@) или семинаристу. Вопросы по материалам лекций/семинаров и по заданиям лучше всего задавать на форуме.

Семинары

| Группа | Преподаватель |

|---|---|

| 191 (МОП) | Хрушков Павел Вадимович |

| 192 (МОП) | Соколов Евгений Андреевич |

| 193 (МОП) | Садртдинов Ильдус Рустемович |

| 194 (АДИС) | Цвигун Аким Олегович |

| 195 (РС) | Каюмов Эмиль Марселевич |

| 196 (РС) | Шабалин Александр Михайлович |

| 197 (АПР) | Глазкова Екатерина Васильевна |

| 198 (ТИ) | Ульянкин Филипп @ppilif |

| 199 (МИ) | Семенкин Антон Александрович |

| 1910 (ПР) | Биршерт Алексей Дмитриевич |

| ФЭН | Зехов Матвей Сергеевич |

| Пермь (БИ) | Собянин Кирилл Валентинович |

| Пермь (ПИ) | Собянин Кирилл Валентинович |

Консультации

Правила выставления оценок

В курсе предусмотрено несколько форм контроля знания:

Итоговая оценка вычисляется на основе оценки за работу в семестре и оценки за экзамен:

Итог = Округление(0.15 * ПР + 0.4 * ДЗ + 0.15 * КР + 0.3 * Э)

ПР — средняя оценка за самостоятельные работы на семинарах

ДЗ — средняя оценка за практические домашние работы на Python

КР — оценка за контрольную работу

Э — оценка за экзамен

Правила сдачи заданий

За каждый день просрочки после мягкого дедлайна снимается 1 балл. После жёсткого дедлайна работы не принимаются. Даже при опоздании на одну секунду. Сдавайте заранее. Есть исключение: в течение семестра каждый студент может не более 2 раз сдать задание после жёсткого дедлайна — в этом случае за каждый день просрочки продолжает вычитаться по одному баллу (если не оговорено иное).

При обнаружении плагиата оценки за домашнее задание обнуляются всем задействованным в списывании студентам, а также подаётся докладная записка в деканат. Следует помнить, что при повторном списывании деканат имеет право отчислить студента.

При наличии уважительной причины пропущенную проверочную можно написать позднее, а дедлайн по домашнему заданию может быть перенесён. Дедлайн по домашнему заданию переносится на количество дней, равное продолжительности уважительной причины. Решение о том, является ли причина уважительной, принимает исключительно учебный офис.

Лекции

Ко всем конспектам на GitHub есть исходники. Исправления и дополнения всячески приветствуются!

Лекция 1 (3 сентября). Введение в машинное обучение. Основные термины, постановки задач и примеры применения. [Конспект] [Запись лекции]

Лекция 2 (10 сентября). Модель линейной регрессии. Подготовка данных для линейных моделей. Измерение ошибки в задачах регрессии. Устойчивые к выбросам функции потерь. Относительные функции потерь. [Конспект] [Запись лекции]

Лекция 3 (17 сентября). Переобучение. Отложенная выборка и кросс-валидация. Аналитическое решение для линейной регрессии и MSE. Градиентный спуск. [Конспект] [Запись лекции]

Лекция 4 (24 сентября). Стохастический градиентный спуск. SAG, Momentum, AdaGrad, Adam. Регуляризация линейных моделей. [Конспект] [Запись лекции]

Лекция 5 (1 октября). Разреженные линейные модели. Линейные классификаторы. Обучение линейных классификаторов через верхние оценки на пороговую функцию потерь. [Конспект] [Запись лекции]

Лекция 6 (8 октября). Метрики качества классификации. Доля верных ответов. Точность, полнота, F-мера и другие способы усреднения. ROC-кривая и PR-кривая, площади под ними. [Конспект] [Запись лекции]

Лекция 7 (15 октября). Оценивание вероятностей. Логистическая регрессия. [Конспект] [Запись лекции]

Лекция 8 (29 октября). Метод опорных векторов. Многоклассовая классификация. Метрики качества многоклассовой классификации. [Конспект по SVM] [Конспект по многоклассовой классификации] [Запись лекции]

Лекция 9 (5 ноября). Решающие деревья. Жадный алгоритм обучения дерева. Функционалы качества предикатов. Связь решающих деревьев и линейных моделей. Разложение ошибки на смещение и разброс. [Конспект по деревьям] [Конспект по BVD] [Запись лекции]

Лекция 10 (12 ноября). Бэггинг и случайные леса. Out-of-bag оценка. Градиентный бустинг. [Конспект по бэггингу и RF] [Конспект по бустингу] [Запись лекции]

Лекция 11 (19 ноября). Градиентный бустинг. Сокращение шага. Стохастический градиентный бустинг. Бустинг над деревьями, дообучение прогнозов в листьях. Бустинг второго порядка. [Конспект по бустингу] [Продолжение конспекта по бустингу] [Запись лекции]

Семинары

Семинар 1. Типы данных и виды задач машинного обучения [Ноутбук]. Библиотека pandas [Ноутбук].

Семинар 2. Исследование данных. Библиотека scikit-learn. Подготовка данных для линейных моделей. [Ноутбук]

Семинар 4. Обработка данных. Работа с категориальными и текстовыми данными. Mean-target encoding. [Конспект] [Ноутбук]

Семинар 5. Метрики качества классификации. [Конспект]

Семинар 6. Оценивание вероятностей классов. Калибровка вероятностей. Квантильная регрессия. [Конспект] [Ноутбук]

Семинар 7. Решающие деревья. Критерии информативности. [Конспект] [Ноутбук]

Семинар 8. Разложение ошибки на смещение и разброс. [Конспект]

Семинар 9. Почему градиентный бустинг так устроен? [Конспект] [Ноутбук]

Практические задания

Задание 1. Pandas и распределение студентов ПМИ по элективам.

Мягкий дедлайн: 25.09.2021 23:59 MSK.

Жесткий дедлайн: 28.09.2021 23:59 MSK.

Задание 2. Разведочный анализ данных, линейная регрессия и разработка признаков.

Мягкий дедлайн: 11.10.2021 23:59 MSK.

Жесткий дедлайн: 14.10.2021 23:59 MSK.

Задание 3. Градиентный спуск своими руками.

Мягкий дедлайн: 27.10.2021 23:59 MSK.

Жесткий дедлайн: 29.10.2021 23:59 MSK.

Задание 4. Классификация.

Мягкий дедлайн: 10.11.2021 23:59 MSK.

Жесткий дедлайн: 13.11.2021 23:59 MSK.

Задание 5. Решающие деревья.

Мягий дедлайн: 23.11.2021 23:59 MSK.

Жестокий дедлайн: 26.11.2021 23:59 MSK.

Теоретические домашние задания

Теоретические ДЗ не проверяются, но задачи из них могут войти в проверочные работы на семинарах.

Соревнования

Правила участия и оценивания

В соревновании по анализу данных вам предлагается по имеющимся данным решить некоторую задачу, оптимизируя указанную метрику, и отправить ответы для заданного тестового множества. Максимальное количество посылок в сутки ограничено (как правило, разрешается сделать 2 посылки), ближе к концу соревнования вам будем необходимо выбрать 2 посылки, которые вы считаете лучшими. Тестовые данные делятся на публичные и приватные в некотором соотношении, на основе которых строятся публичный и приватный лидерборды соответственно, при этом публичный лидерборд доступен в течение всего соревнования, а приватный строится после его окончания для выбранных вами посылок.

В лидербордах каждого из соревнований присутствуют несколько базовых решений (бейзлайнов), каждое из которых соответствует определённой оценке. Например, для получения оценки не ниже 8 баллов необходимо, чтобы ваше решение на приватном лидерборде оказалось лучше соответствующего бейзлайна. Далее для студента, преодолевшего бейзлайн на N_1 баллов, но не преодолевшего бейзлайн на N_2 балла, итоговая оценка за соревнование рассчитывается по равномерной сетке среди всех таких студентов в зависимости от места в приватном лидерборде среди них; если быть точными, то по следующей формуле:

где M — количество студентов (из всех студентов, изучающих курс), преодолевших бейзлайн на N_1 баллов, но не преодолевших бейзлайн на N_2 балла;

i — место (начиная с 1) студента в приватном лидерборде среди всех таких студентов.

Единственное исключение из формулы — студенты, преодолевшие самый сильный бейзлайн, получают прибавку 1/M к своей оценке.

Чтобы вас не пропустили при проверке решений соревнования, необходимо использовать следующий формат для имени команды (вкладка Team):

«[ПМИ] Имя Фамилия номер_группы»

В течение 3 суток после окончания соревнования в соответствующее задание на anytask необходимо прислать код, воспроизводящий ответы для посылки, фигурирующей в приватном лидерборде. При оформлении кода предполагайте, что данные лежат рядом с ним в папке data, а в результате выполнения кода ответы должны быть записаны в файл solution-N-Username.csv, где N — номер соревнования, Username — ваша фамилия. У нас должна быть возможность запустить код и получить те же ответы, что и в вашей посылке, — в частности, это означает, что:

1. Если вы отправляете файл *.py, мы будем запускать его при помощи команды python *.py в вышеуказанном предположении о местонахождении данных.

2. Если вы отправляете ноутбук *.ipynb, мы последовательно запустим все ячейки ноутбука и будем ожидать в результате его работы формирование файла с ответами.

3. Если вы отправляете код с использованием другого языка программирования, в том же письме направьте нам инструкцию по его запуску с тем, чтобы получить тот же файл с ответами.

В случае отсутствия кода, воспроизводящего результат, в установленный срок студенту выставляется 0 в качестве оценки за соревнование. Студенты, попавшие в топ-3 согласно приватному лидерборду, смогут получить бонусные баллы, если в течение недели после окончания соревнования сдадут в anytask отчет о получении решения, фигурирующего в приватном лидерборде. Если не оговорено иное, использовать любые внешние данные в соревнованиях запрещено. Под внешними данными понимаются размеченные данные, где разметка имеет прямое отношение к решаемой задаче. Грубо говоря, сборник текстов с википедии не считается внешними данными.

В некоторых соревнованиях данные взяты из завершившегося соревнования на Kaggle. Категорически запрещено использовать данные из оригинального соревнования для восстановления целевой переменной на тестовой выборке.

Соревнование 1

Задача: выявление мошеннических тразнакций

Это соревнование на бонусные баллы, оно не является обязательным.

Дедлайн: 13.12.2021 23:59MSK

В задании всего один бейзлайн (lightgbm), ненулевые баллы получают решения, преодолевшие его на приватном лидерборде. Все решения выше этого бейзлайна оцениваются по равномерной шкале от 0 до 5.

Обратите внимание на раздел Baselines на Kaggle — там можно найти много полезного.

Бонусы за соревнования

За успешное участие в соревнованиях по анализу данных могут быть выставлены бонусные баллы, которые можно прибавить к оценке за любое практическое или теоретическое домашнее задание, а также за самостоятельную работу. Под успешным участием понимается попадание в топ-10% мест; если соревнование особо сложное и крупное, может рассматриваться и попадание в топ-20% мест. Конкретное число баллов определяется преподавателями и зависит от сложности соревнования и занятого места. За одно соревнование можно получить не более 5 баллов. Для получения оценки необходимо предоставить краткий отчёт о решении задачи.

Контрольная работа

Контрольная работа состоится 3 декабря на лекции. Продолжительность — 80 минут. Проходит в zoom, студенты должны будут писать работу с включенным камерами и расшаренным экраном. На фотографирование и сдачу листочков дополнительно даётся 5 минут.